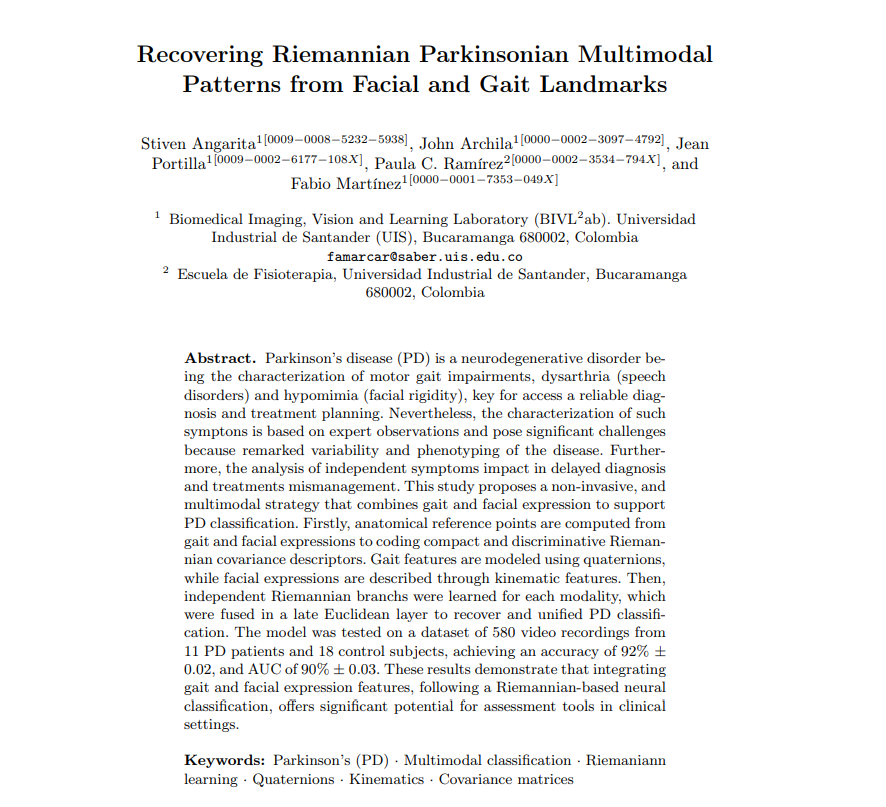

Modelo para clasificar la Enfermedad de Parkinson

Este modelo genera predicciones precisas para ayudar en la detección temprana de la Enfermedad de Parkinson, mejorando la calidad de vida de los pacientes.

Descripción del proyecto

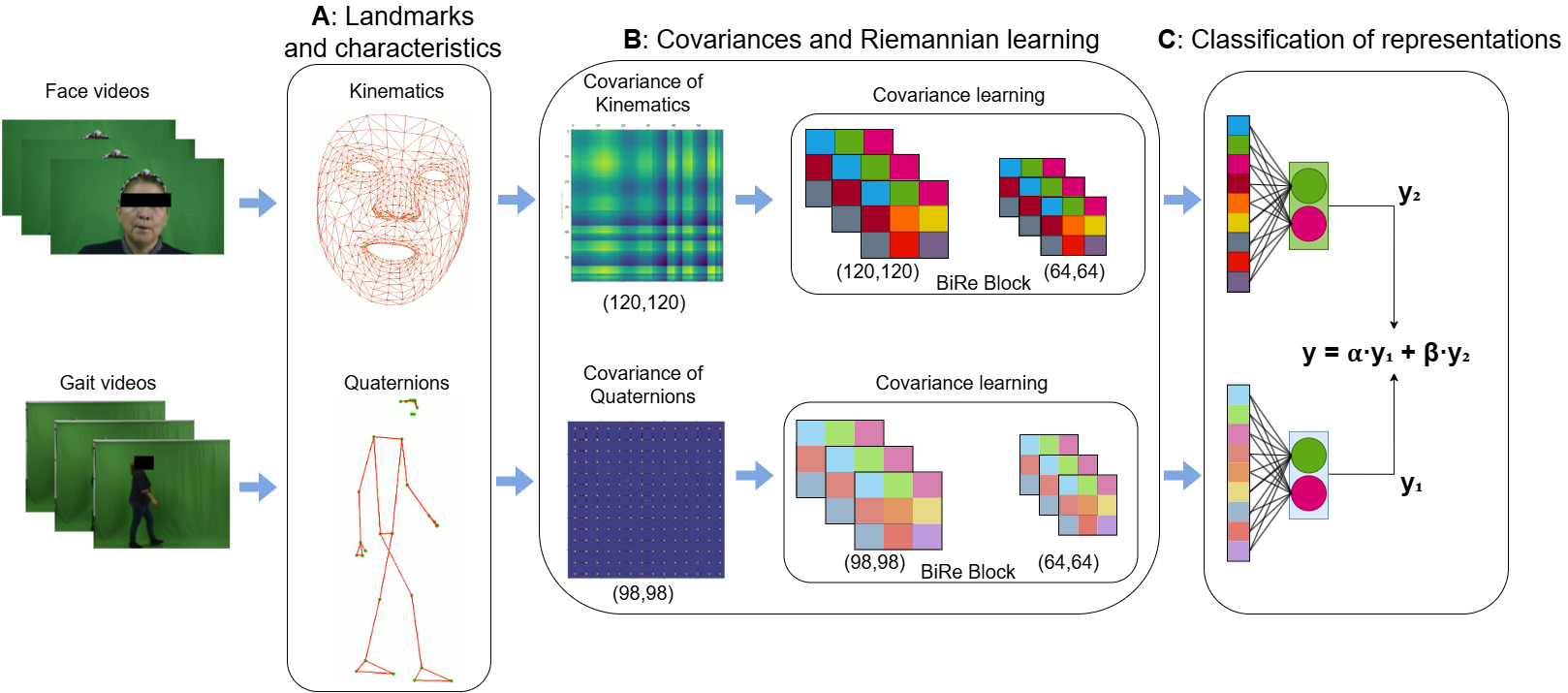

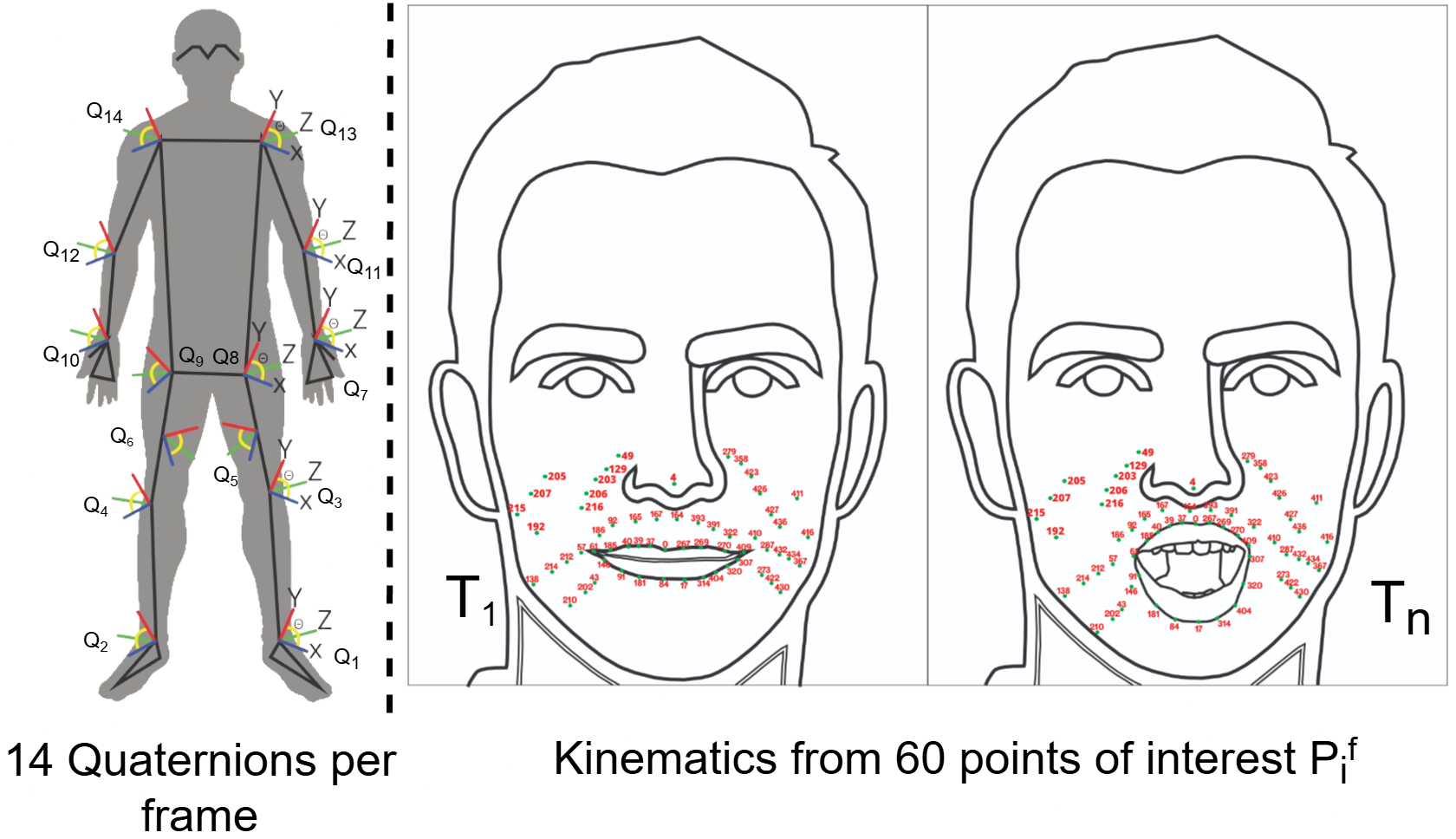

Estrategia no invasiva y multimodal para apoyar la clasificación de Enfermedad de Parkinson (EP) a partir de video, integrando dos señales clínicas complementarias: marcha y expresión facial durante ejercicios de habla. El proyecto busca reducir la dependencia de evaluaciones únicamente observacionales y capturar patrones motores que pueden manifestarse en distintos momentos de la progresión. Mi aporte se centró en el diseño del pipeline de representación geométrica: extracción de landmarks, construcción de descriptores de covarianza (matrices SPD) y entrenamiento de un modelo de aprendizaje Riemanniano con ramas por modalidad y fusión tardía para una predicción unificada.

El diagnóstico y seguimiento de la EP se apoya en observación clínica (marcha, hipomimia, disartria), lo que introduce variabilidad entre evaluadores y pacientes. Además, los enfoques computacionales unimodales suelen fallar cuando el síntoma dominante no queda bien representado en la señal analizada (solo marcha o solo cara), generando errores y limitando el soporte temprano.

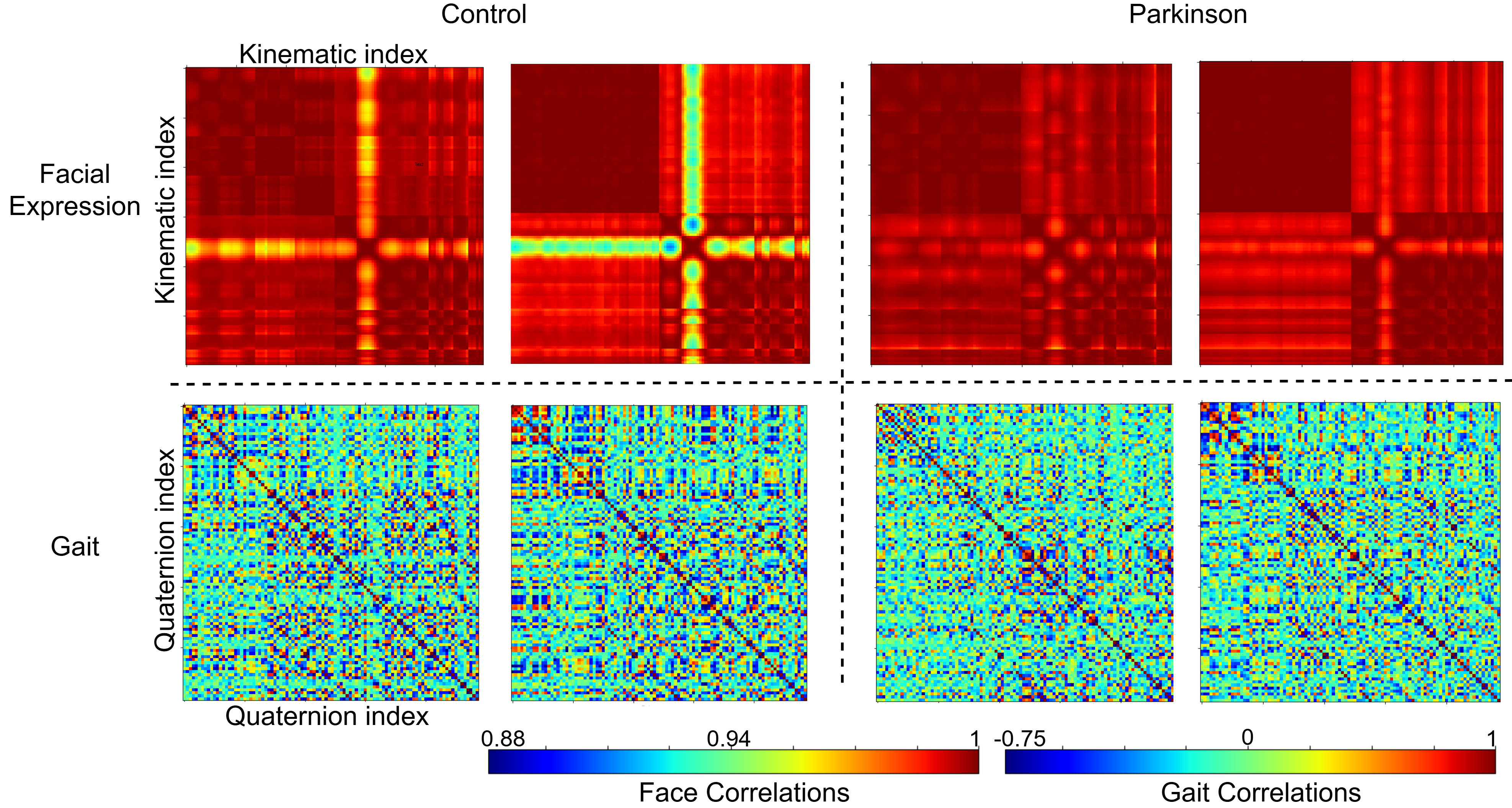

Se extrajeron puntos anatómicos del cuerpo y marcadores faciales desde videos. La marcha se modeló con quaternions para capturar rotación/articulación, y la cara con cinemática (posición, velocidad, aceleración). Luego se construyeron descriptores de covarianza (SPD) y se entrenaron ramas Riemannianas independientes por modalidad, fusionadas en una capa Euclidiana final para clasificar EP vs controles.

Highlights

- check_circle Pipeline no invasivo basado en video: extracción de landmarks corporales y faciales sin sensores físicos.

- check_circle Representación de segundo orden con matrices de covarianza SPD y aprendizaje geométrico en variedad Riemanniana.

- check_circle Fusión tardía multimodal (marcha + cara) para robustez ante variabilidad de síntomas entre pacientes.

Resultados

Evaluado en 580 grabaciones de video (11 pacientes con EP y 18 controles), el modelo alcanzó 92% ± 0.02 de accuracy y 0.90 ± 0.03 de AUC. Los resultados muestran que integrar marcha y expresión facial con aprendizaje Riemanniano mejora la discriminación frente a enfoques unimodales y aporta potencial para herramientas de apoyo en entornos clínicos.